“假聲音”也來(lái)了,手把手教你造一只柯南的蝴蝶結(jié)變聲器互聯(lián)網(wǎng)+

導(dǎo)讀

“假臉”技術(shù)大肆盛行,與之配套的“假聲音”上線后,更能生成無(wú)縫銜接的假視頻,讓假戲做足,真假難辨。

“假臉”技術(shù)大肆盛行,與之配套的“假聲音”上線后,更能生成無(wú)縫銜接的假視頻,讓假戲做足,真假難辨。

最近,一只“總統(tǒng)洋蔥新聞”在Youtube和Reddit上引發(fā)了一波討論。

視頻中,特朗普用它一貫懶散的聲音播報(bào)了一組耐人尋味的新聞——“數(shù)據(jù)雨“:

視頻地址:

https://www.youtube.com/watch?v=jzKlTKsHeus

視頻地址:

https://www.youtube.com/watch?v=jzKlTKsHeus

雖然內(nèi)容荒唐,但整個(gè)視頻中的聲音效果非常真實(shí),以至于不少網(wǎng)友在捧腹大笑的同時(shí)也開始調(diào)侃,“是不是很快就能接到特朗普給我打的廣告電話了。”

再加上近期,“假臉”技術(shù)大肆盛行,與之配套的“假聲音”上線后,更能生成無(wú)縫銜接的假視頻,讓假戲做足,真假難辨。

靠換臉技術(shù)”出演”《射雕英雄傳》的楊冪

關(guān)于變音技術(shù),江湖上確實(shí)流傳了幾種,不過(guò)加持了機(jī)器學(xué)習(xí)和深度學(xué)習(xí),這種技術(shù)不再是簡(jiǎn)單的語(yǔ)音濾波器。

聽聽下面的聲音? 合成語(yǔ)音.mp300:40 是不是后面兩種語(yǔ)音的音調(diào)、停頓以及語(yǔ)氣和第一種幾乎都一模一樣。

跟”一鍵變臉“的deepfake軟件一樣,研究者們也開發(fā)了讓不懂技術(shù)的同學(xué)直接易上手的變聲軟件。

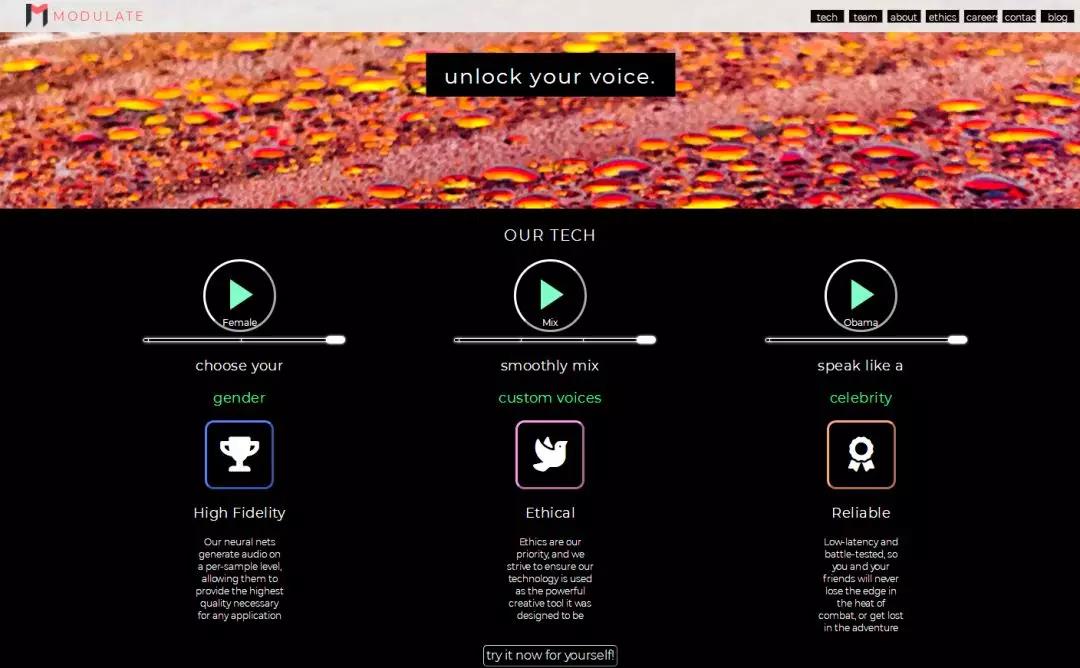

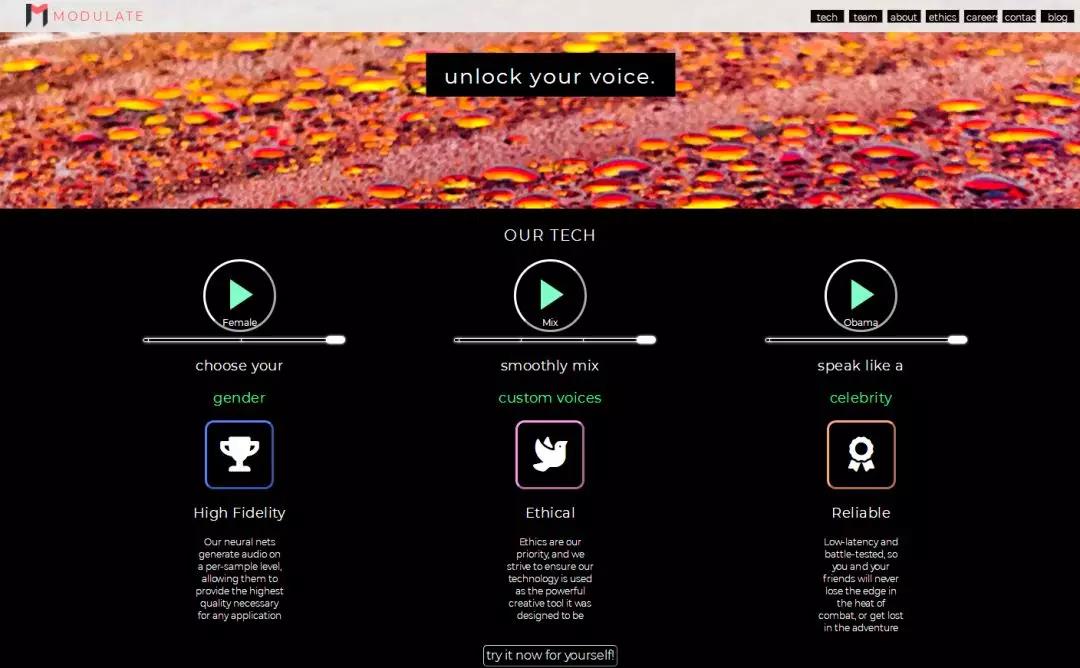

剛剛聽到的這個(gè)聲音就來(lái)自這樣一個(gè)網(wǎng)站Modulate.ai。麻省理工科技評(píng)論的資深編輯Will Knight用其輕易就合成了不同的聲音。

創(chuàng)建這個(gè)網(wǎng)站的三個(gè)小伙伴,有兩個(gè)來(lái)自麻省理工,還有一個(gè)來(lái)自加州大學(xué)洛杉磯分校。對(duì)于游客,這個(gè)網(wǎng)站給出了幾個(gè)適用的聲音,對(duì)于想定制名人聲音的用戶,還得通過(guò)官網(wǎng)給出的聯(lián)系方式聯(lián)系他們。

據(jù)網(wǎng)站介紹,合成的聲音是是采用神經(jīng)網(wǎng)絡(luò)訓(xùn)練來(lái)訓(xùn)練,具有低延遲性以及實(shí)時(shí)性。

文摘菌試了一把,在網(wǎng)站的提供的接口處錄下聲音,選擇你想要的“性別”或者“名人”,網(wǎng)站會(huì)很快生成你想要的聲音。

網(wǎng)站地址:

https://modulate.ai/

網(wǎng)站地址:

https://modulate.ai/

此外,百度在18年的3月份曾經(jīng)宣布,百度開發(fā)的新 AI 算法Deep Voice可以通過(guò)3.7秒鐘的錄音樣本數(shù)據(jù)就能完美的克隆出一個(gè)人的聲音。Deep Voice是百度AI研究院一個(gè)由深度神經(jīng)網(wǎng)絡(luò)構(gòu)建的高質(zhì)量語(yǔ)音轉(zhuǎn)(TTS )系統(tǒng)。除了利用少量樣本克隆聲音外,系統(tǒng)還能將女性聲音轉(zhuǎn)變成男性,英式聲音變成美式。

聲音的直接轉(zhuǎn)換是比較復(fù)雜的,因?yàn)橐粋€(gè)人的“聲音”不僅是由聲帶定義,聲帶只是聲音的頻率,具體來(lái)說(shuō),還取決于口音和說(shuō)話風(fēng)格。另外,音高會(huì)受胸腔的物理特性等的影響。這些影響作用在不同的層面上,發(fā)音決定了單詞和短語(yǔ)是如何在幾秒鐘或幾十秒內(nèi)被識(shí)別出來(lái)。

當(dāng)開始合成語(yǔ)音時(shí),技術(shù)人員主要會(huì)考慮三個(gè)因素。

首先是生物因素,這些因素人們難以自行改變。第二,構(gòu)建聲音認(rèn)同概念,即任何在語(yǔ)言下明顯表現(xiàn)出來(lái)的同一性。有了這個(gè)定義,就可以很好的建立語(yǔ)音識(shí)別模型。第三,建立獨(dú)立于上下文處理語(yǔ)音片段的模型,這個(gè)模型的好處是它比神經(jīng)網(wǎng)絡(luò)中所要處理的序列模型要簡(jiǎn)單的多,并且可以有效的降低語(yǔ)音處理延遲。

總的來(lái)說(shuō),所要建立的系統(tǒng)是:把一個(gè)說(shuō)話人的聲音的頻率分布(frequency profile)換成另一個(gè)聲音的頻率分布,同時(shí)保持他們講話的其余屬性不變。

所以,自然的將系統(tǒng)分為兩個(gè)部分:1、語(yǔ)音識(shí)別 2、語(yǔ)音轉(zhuǎn)換。這兩個(gè)部分最主要的區(qū)別是,是從語(yǔ)音轉(zhuǎn)換到文本,還是從文本轉(zhuǎn)換到語(yǔ)音。如果這兩個(gè)部分獨(dú)立運(yùn)行,那么整個(gè)系丟失“情感模仿”。

語(yǔ)音轉(zhuǎn)文本和文本轉(zhuǎn)語(yǔ)音同屬一個(gè)極端的情況。語(yǔ)音轉(zhuǎn)換必須使用媒介,由于系統(tǒng)只能給出語(yǔ)音,并且嘗試在輸出中再現(xiàn)輸入的語(yǔ)句。

通過(guò)限制某時(shí)段通過(guò)系統(tǒng)的信息量,系統(tǒng)學(xué)習(xí)識(shí)別功能(identity function),這是系統(tǒng)的瓶頸。在從語(yǔ)音到文本到語(yǔ)音的情況下,瓶頸在于對(duì)輸入的語(yǔ)音進(jìn)行文本表示,因此系統(tǒng)必須進(jìn)行一般性學(xué)習(xí),才能根據(jù)文本生成可靠的語(yǔ)音。

從通過(guò)機(jī)器學(xué)習(xí)構(gòu)建這樣一個(gè)系統(tǒng)的角度來(lái)看,出現(xiàn)瓶頸自然有其的道理。機(jī)器學(xué)習(xí),特別是深度學(xué)習(xí),當(dāng)被訓(xùn)練來(lái)完成一項(xiàng)特定的任務(wù)時(shí),一直表現(xiàn)得非常好。但是瓶頸自動(dòng)編碼器沒(méi)有接受過(guò)語(yǔ)音轉(zhuǎn)換的訓(xùn)練,他們接受的是自動(dòng)編碼訓(xùn)練。

破解瓶頸的主要方法是調(diào)整信息瓶頸的帶寬。例如文本中間表示,會(huì)丟失太多信息。文本可以使用情感標(biāo)簽或其他符號(hào)進(jìn)行注釋,但這些需要對(duì)監(jiān)督數(shù)據(jù)著重進(jìn)行手動(dòng)注釋。

具體的步驟:

首先嘗試在兩種不同的損失函數(shù)上訓(xùn)練說(shuō)話人標(biāo)識(shí)符( identifie):真實(shí)音頻匹配揚(yáng)聲器配置文件和生成音頻,以及真實(shí)音頻匹配揚(yáng)聲器配置文件和真實(shí)音頻的揚(yáng)聲器配置文件。使得說(shuō)話人的標(biāo)識(shí)符“尋找”說(shuō)話人身份,否則它只能關(guān)注于檢測(cè)生成的音頻。在實(shí)踐中,發(fā)現(xiàn)只有對(duì)兩個(gè)損失函數(shù)中的第一個(gè)函數(shù)的訓(xùn)練才能起到同樣的作用:說(shuō)話人標(biāo)識(shí)符首先學(xué)會(huì)區(qū)分真實(shí)的音頻和生成的音頻,然后隨著生成器開始產(chǎn)生更高質(zhì)量的輸出,自然進(jìn)化到使用說(shuō)話人配置文件。

在神經(jīng)網(wǎng)絡(luò)的輸入層對(duì)說(shuō)話人標(biāo)識(shí)符的大小設(shè)置了懲罰。懲罰的大小是一個(gè)可調(diào)整的參數(shù),通過(guò)訓(xùn)練效果進(jìn)步明顯與否,可以判斷最優(yōu)參數(shù)。對(duì)于真實(shí)和假音頻,我們最好的訓(xùn)練傾向于快速收斂0.55的交叉熵,然后在大多數(shù)訓(xùn)練過(guò)程中慢慢爬過(guò)0.6。

然后繼續(xù)改進(jìn)系統(tǒng)系結(jié)構(gòu),通過(guò)直接優(yōu)化語(yǔ)音轉(zhuǎn)換目標(biāo),通過(guò)一個(gè)新的說(shuō)話人標(biāo)識(shí)符,能夠產(chǎn)生與目標(biāo)聲音緊密匹配的合成語(yǔ)音,同時(shí)保留了通常由瓶頸架構(gòu)丟失的表達(dá)性。

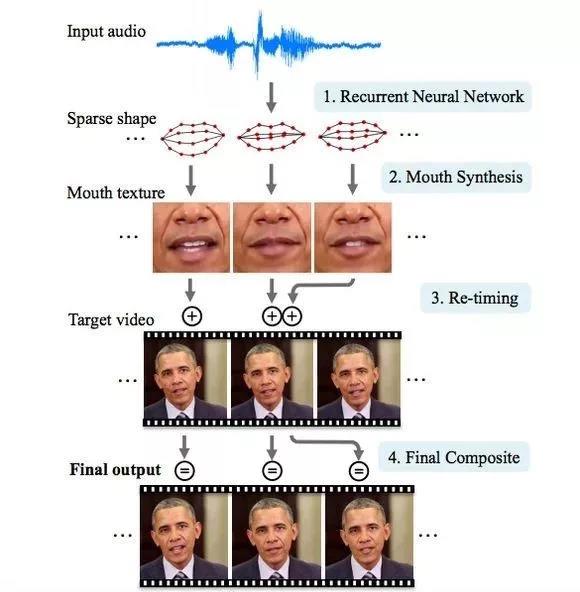

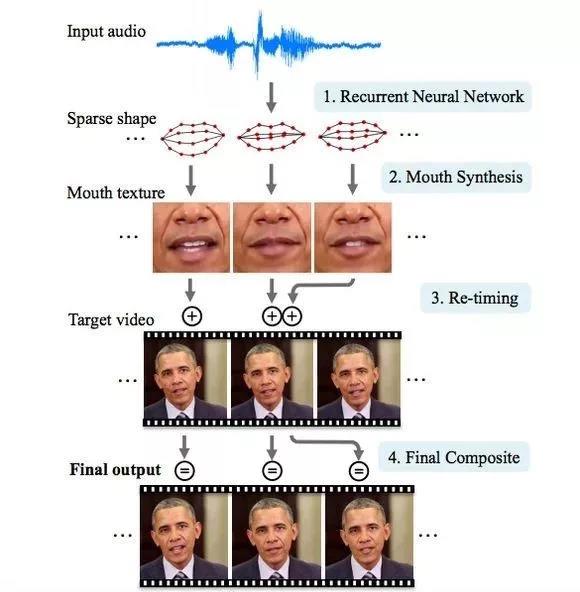

AI合成大事件 通過(guò)AI技術(shù)合成圖片以及視頻早已不新鮮,要說(shuō)最著名的合成案例可能就是下面這個(gè)。

這項(xiàng)技術(shù)由華盛頓大學(xué)SUPASORN SUWAJANAKORN等三人共同發(fā)明,他們坦言,之所以選用奧巴馬做研究范例,是因?yàn)樗母咔逡曨l資源獲取非常容易,并且不受版權(quán)限制。

因此,研究小組用神經(jīng)網(wǎng)絡(luò)分析了數(shù)百萬(wàn)幀的視頻,來(lái)確定奧巴馬的面部表情如何變化。開口說(shuō)話需要整個(gè)面部器官的協(xié)調(diào),所以研究人員不僅分析了口型變化,還包括他的嘴唇、牙齒和下巴周圍的皺紋,甚至還包括脖子與衣領(lǐng)。

具體的操作過(guò)程是:研究人員采集了音頻片段(原始音頻文件),再把口型和新的音頻文件剪輯匹配,再嫁接到新視頻。

具體的操作過(guò)程是:研究人員采集了音頻片段(原始音頻文件),再把口型和新的音頻文件剪輯匹配,再嫁接到新視頻。

國(guó)內(nèi)的科技公司也在這一領(lǐng)域各有千秋。拿導(dǎo)航用的語(yǔ)音來(lái)說(shuō),科大訊飛的董事長(zhǎng)劉慶峰在2018世界機(jī)器人大會(huì)上表示,高德地圖導(dǎo)航上面的林志玲、郭德綱的聲音都是合成,其實(shí)都不是本人原音,而是由他們的機(jī)器來(lái)完成合成的,壓根就不是本人錄的。

視頻中,特朗普用它一貫懶散的聲音播報(bào)了一組耐人尋味的新聞——“數(shù)據(jù)雨“:

視頻地址:

https://www.youtube.com/watch?v=jzKlTKsHeus

視頻地址:

https://www.youtube.com/watch?v=jzKlTKsHeus

雖然內(nèi)容荒唐,但整個(gè)視頻中的聲音效果非常真實(shí),以至于不少網(wǎng)友在捧腹大笑的同時(shí)也開始調(diào)侃,“是不是很快就能接到特朗普給我打的廣告電話了。”

再加上近期,“假臉”技術(shù)大肆盛行,與之配套的“假聲音”上線后,更能生成無(wú)縫銜接的假視頻,讓假戲做足,真假難辨。

靠換臉技術(shù)”出演”《射雕英雄傳》的楊冪

關(guān)于變音技術(shù),江湖上確實(shí)流傳了幾種,不過(guò)加持了機(jī)器學(xué)習(xí)和深度學(xué)習(xí),這種技術(shù)不再是簡(jiǎn)單的語(yǔ)音濾波器。

聽聽下面的聲音? 合成語(yǔ)音.mp300:40 是不是后面兩種語(yǔ)音的音調(diào)、停頓以及語(yǔ)氣和第一種幾乎都一模一樣。

跟”一鍵變臉“的deepfake軟件一樣,研究者們也開發(fā)了讓不懂技術(shù)的同學(xué)直接易上手的變聲軟件。

剛剛聽到的這個(gè)聲音就來(lái)自這樣一個(gè)網(wǎng)站Modulate.ai。麻省理工科技評(píng)論的資深編輯Will Knight用其輕易就合成了不同的聲音。

創(chuàng)建這個(gè)網(wǎng)站的三個(gè)小伙伴,有兩個(gè)來(lái)自麻省理工,還有一個(gè)來(lái)自加州大學(xué)洛杉磯分校。對(duì)于游客,這個(gè)網(wǎng)站給出了幾個(gè)適用的聲音,對(duì)于想定制名人聲音的用戶,還得通過(guò)官網(wǎng)給出的聯(lián)系方式聯(lián)系他們。

據(jù)網(wǎng)站介紹,合成的聲音是是采用神經(jīng)網(wǎng)絡(luò)訓(xùn)練來(lái)訓(xùn)練,具有低延遲性以及實(shí)時(shí)性。

文摘菌試了一把,在網(wǎng)站的提供的接口處錄下聲音,選擇你想要的“性別”或者“名人”,網(wǎng)站會(huì)很快生成你想要的聲音。

網(wǎng)站地址:

https://modulate.ai/

網(wǎng)站地址:

https://modulate.ai/

此外,百度在18年的3月份曾經(jīng)宣布,百度開發(fā)的新 AI 算法Deep Voice可以通過(guò)3.7秒鐘的錄音樣本數(shù)據(jù)就能完美的克隆出一個(gè)人的聲音。Deep Voice是百度AI研究院一個(gè)由深度神經(jīng)網(wǎng)絡(luò)構(gòu)建的高質(zhì)量語(yǔ)音轉(zhuǎn)(TTS )系統(tǒng)。除了利用少量樣本克隆聲音外,系統(tǒng)還能將女性聲音轉(zhuǎn)變成男性,英式聲音變成美式。

聲音的直接轉(zhuǎn)換是比較復(fù)雜的,因?yàn)橐粋€(gè)人的“聲音”不僅是由聲帶定義,聲帶只是聲音的頻率,具體來(lái)說(shuō),還取決于口音和說(shuō)話風(fēng)格。另外,音高會(huì)受胸腔的物理特性等的影響。這些影響作用在不同的層面上,發(fā)音決定了單詞和短語(yǔ)是如何在幾秒鐘或幾十秒內(nèi)被識(shí)別出來(lái)。

當(dāng)開始合成語(yǔ)音時(shí),技術(shù)人員主要會(huì)考慮三個(gè)因素。

首先是生物因素,這些因素人們難以自行改變。第二,構(gòu)建聲音認(rèn)同概念,即任何在語(yǔ)言下明顯表現(xiàn)出來(lái)的同一性。有了這個(gè)定義,就可以很好的建立語(yǔ)音識(shí)別模型。第三,建立獨(dú)立于上下文處理語(yǔ)音片段的模型,這個(gè)模型的好處是它比神經(jīng)網(wǎng)絡(luò)中所要處理的序列模型要簡(jiǎn)單的多,并且可以有效的降低語(yǔ)音處理延遲。

總的來(lái)說(shuō),所要建立的系統(tǒng)是:把一個(gè)說(shuō)話人的聲音的頻率分布(frequency profile)換成另一個(gè)聲音的頻率分布,同時(shí)保持他們講話的其余屬性不變。

所以,自然的將系統(tǒng)分為兩個(gè)部分:1、語(yǔ)音識(shí)別 2、語(yǔ)音轉(zhuǎn)換。這兩個(gè)部分最主要的區(qū)別是,是從語(yǔ)音轉(zhuǎn)換到文本,還是從文本轉(zhuǎn)換到語(yǔ)音。如果這兩個(gè)部分獨(dú)立運(yùn)行,那么整個(gè)系丟失“情感模仿”。

語(yǔ)音轉(zhuǎn)文本和文本轉(zhuǎn)語(yǔ)音同屬一個(gè)極端的情況。語(yǔ)音轉(zhuǎn)換必須使用媒介,由于系統(tǒng)只能給出語(yǔ)音,并且嘗試在輸出中再現(xiàn)輸入的語(yǔ)句。

通過(guò)限制某時(shí)段通過(guò)系統(tǒng)的信息量,系統(tǒng)學(xué)習(xí)識(shí)別功能(identity function),這是系統(tǒng)的瓶頸。在從語(yǔ)音到文本到語(yǔ)音的情況下,瓶頸在于對(duì)輸入的語(yǔ)音進(jìn)行文本表示,因此系統(tǒng)必須進(jìn)行一般性學(xué)習(xí),才能根據(jù)文本生成可靠的語(yǔ)音。

從通過(guò)機(jī)器學(xué)習(xí)構(gòu)建這樣一個(gè)系統(tǒng)的角度來(lái)看,出現(xiàn)瓶頸自然有其的道理。機(jī)器學(xué)習(xí),特別是深度學(xué)習(xí),當(dāng)被訓(xùn)練來(lái)完成一項(xiàng)特定的任務(wù)時(shí),一直表現(xiàn)得非常好。但是瓶頸自動(dòng)編碼器沒(méi)有接受過(guò)語(yǔ)音轉(zhuǎn)換的訓(xùn)練,他們接受的是自動(dòng)編碼訓(xùn)練。

破解瓶頸的主要方法是調(diào)整信息瓶頸的帶寬。例如文本中間表示,會(huì)丟失太多信息。文本可以使用情感標(biāo)簽或其他符號(hào)進(jìn)行注釋,但這些需要對(duì)監(jiān)督數(shù)據(jù)著重進(jìn)行手動(dòng)注釋。

具體的步驟:

首先嘗試在兩種不同的損失函數(shù)上訓(xùn)練說(shuō)話人標(biāo)識(shí)符( identifie):真實(shí)音頻匹配揚(yáng)聲器配置文件和生成音頻,以及真實(shí)音頻匹配揚(yáng)聲器配置文件和真實(shí)音頻的揚(yáng)聲器配置文件。使得說(shuō)話人的標(biāo)識(shí)符“尋找”說(shuō)話人身份,否則它只能關(guān)注于檢測(cè)生成的音頻。在實(shí)踐中,發(fā)現(xiàn)只有對(duì)兩個(gè)損失函數(shù)中的第一個(gè)函數(shù)的訓(xùn)練才能起到同樣的作用:說(shuō)話人標(biāo)識(shí)符首先學(xué)會(huì)區(qū)分真實(shí)的音頻和生成的音頻,然后隨著生成器開始產(chǎn)生更高質(zhì)量的輸出,自然進(jìn)化到使用說(shuō)話人配置文件。

在神經(jīng)網(wǎng)絡(luò)的輸入層對(duì)說(shuō)話人標(biāo)識(shí)符的大小設(shè)置了懲罰。懲罰的大小是一個(gè)可調(diào)整的參數(shù),通過(guò)訓(xùn)練效果進(jìn)步明顯與否,可以判斷最優(yōu)參數(shù)。對(duì)于真實(shí)和假音頻,我們最好的訓(xùn)練傾向于快速收斂0.55的交叉熵,然后在大多數(shù)訓(xùn)練過(guò)程中慢慢爬過(guò)0.6。

然后繼續(xù)改進(jìn)系統(tǒng)系結(jié)構(gòu),通過(guò)直接優(yōu)化語(yǔ)音轉(zhuǎn)換目標(biāo),通過(guò)一個(gè)新的說(shuō)話人標(biāo)識(shí)符,能夠產(chǎn)生與目標(biāo)聲音緊密匹配的合成語(yǔ)音,同時(shí)保留了通常由瓶頸架構(gòu)丟失的表達(dá)性。

AI合成大事件 通過(guò)AI技術(shù)合成圖片以及視頻早已不新鮮,要說(shuō)最著名的合成案例可能就是下面這個(gè)。

這項(xiàng)技術(shù)由華盛頓大學(xué)SUPASORN SUWAJANAKORN等三人共同發(fā)明,他們坦言,之所以選用奧巴馬做研究范例,是因?yàn)樗母咔逡曨l資源獲取非常容易,并且不受版權(quán)限制。

因此,研究小組用神經(jīng)網(wǎng)絡(luò)分析了數(shù)百萬(wàn)幀的視頻,來(lái)確定奧巴馬的面部表情如何變化。開口說(shuō)話需要整個(gè)面部器官的協(xié)調(diào),所以研究人員不僅分析了口型變化,還包括他的嘴唇、牙齒和下巴周圍的皺紋,甚至還包括脖子與衣領(lǐng)。

具體的操作過(guò)程是:研究人員采集了音頻片段(原始音頻文件),再把口型和新的音頻文件剪輯匹配,再嫁接到新視頻。

具體的操作過(guò)程是:研究人員采集了音頻片段(原始音頻文件),再把口型和新的音頻文件剪輯匹配,再嫁接到新視頻。

國(guó)內(nèi)的科技公司也在這一領(lǐng)域各有千秋。拿導(dǎo)航用的語(yǔ)音來(lái)說(shuō),科大訊飛的董事長(zhǎng)劉慶峰在2018世界機(jī)器人大會(huì)上表示,高德地圖導(dǎo)航上面的林志玲、郭德綱的聲音都是合成,其實(shí)都不是本人原音,而是由他們的機(jī)器來(lái)完成合成的,壓根就不是本人錄的。

1.TMT觀察網(wǎng)遵循行業(yè)規(guī)范,任何轉(zhuǎn)載的稿件都會(huì)明確標(biāo)注作者和來(lái)源;

2.TMT觀察網(wǎng)的原創(chuàng)文章,請(qǐng)轉(zhuǎn)載時(shí)務(wù)必注明文章作者和"來(lái)源:TMT觀察網(wǎng)",不尊重原創(chuàng)的行為TMT觀察網(wǎng)或?qū)⒆肪控?zé)任;

3.作者投稿可能會(huì)經(jīng)TMT觀察網(wǎng)編輯修改或補(bǔ)充。