文生視頻路在何方?萬興科技旗下萬興“天幕”或提出破局之法觀點

隨著Sora驗證算法可行性后,行業(yè)玩家們未來又將如何打出差異化、實現(xiàn)真正落地?

衣著精致的女人行走在東京街頭,身著宇航服的宇航員正以堅毅的目光注視前方,頭頂黃色氣球的氣球人在跑跑跳跳……繼文本、圖像后,視頻行業(yè)也正在接受AI技術(shù)的重塑,不少人認為“AI視頻元年”已至。視頻為何會成為AI技術(shù)最后探索的領(lǐng)域?隨著Sora驗證算法可行性后,行業(yè)玩家們未來又將如何打出差異化、實現(xiàn)真正落地?

當(dāng)我們談?wù)揂I視頻,我們在談?wù)撌裁矗?/strong>

現(xiàn)階段,提及“AI視頻”,似乎包羅萬象——從文生視頻大模型Sora、Runway、快手可靈、萬興“天幕”,到虛擬人視頻HeyGen、萬興播爆、Synthesia,再到AI風(fēng)格化視頻DemoAI等,甚至包括文字快剪等AI剪輯技術(shù)……一切與“AI+視頻”兩大元素相關(guān)的都可歸為這一概念,也讓行業(yè)對AI視頻的探討稍顯不聚焦。

事實上,細究以上所有AI視頻的分支,可以發(fā)現(xiàn)雖然都是AI技術(shù)加持下生成的視頻,但其背后的技術(shù)路徑卻大相徑庭。

以HeyGen、萬興播爆為代表的虛擬人視頻生成主要依靠虛擬人技術(shù),涵蓋了面部識別處理、建模、渲染、驅(qū)動等技術(shù)過程,AI主要體現(xiàn)在驅(qū)動虛擬人形象層面,應(yīng)用場景也主要集中于口播營銷、新聞播報等需要人物形象穩(wěn)定出鏡的類別;以DemoAI為代表的AI風(fēng)格化視頻,則是通過將一段原始視頻拆解的每一幀原始圖像替換為AI風(fēng)格化圖像,再最終合并成一段完整的AI視頻形態(tài)。

這兩種技術(shù),都是“從有到有”“從視覺到視覺”,而實現(xiàn)“從無到有”的,則是文生視頻技術(shù),或者說是難度指數(shù)級升級版本的文生圖技術(shù)。

文生視頻技術(shù)可簡要分為“Sora前”和“Sora后”。在Sora橫空出世之前,文生視頻一直受限于時長,被稱為“10秒以內(nèi)的時代”,而Pika和Runway則是AI視頻領(lǐng)域呼聲最高的商業(yè)類應(yīng)用。

在這個階段,文生視頻技術(shù)基本建立在AI繪畫的基礎(chǔ)操作之上,本質(zhì)上是對圖像這一基礎(chǔ)單位更為復(fù)雜的控制生成,需要對圖像這一基礎(chǔ)單位建立向前和向后等更為復(fù)雜的時空邏輯關(guān)系,其視頻訓(xùn)練的本質(zhì)也是拆解到對關(guān)鍵幀圖像的理解,主要技術(shù)路徑依靠擴散模型。在很長一段時間內(nèi),文生視頻技術(shù)都以相對較慢的速度向前發(fā)展。

AI視頻為何受限于“10秒以內(nèi)”?

相較語言大模型、文生圖技術(shù)在短時間內(nèi)相繼迎來技術(shù)突破,并迎來市場爆火,文生視頻技術(shù)的進展顯得尤為緩慢。控制、時間連貫性、長度是其中的主要問題。

控制,顧名思義,要求算法對視頻內(nèi)所有物體以及發(fā)生的情節(jié)的絕對性控制,而控制背后的邏輯則是算法對不同物體之間物理關(guān)系的透徹理解。AIGC軟件A股上市公司萬興科技(300624.SZ)董事長吳太兵在采訪中指出,如果說文本大模型只需要理解人類,那么視頻大模型需要處理和還原視覺與聽覺等信息,相當(dāng)于理解并構(gòu)建一個接近真實的世界,這意味著指數(shù)級上升的數(shù)據(jù)和學(xué)習(xí)成本。

眾所周知,視頻里包含了大量的交互鏡頭,包括人與人、人與物體、物體與物體的交互。當(dāng)一個人行走,他的手臂如何自然擺動、走的每一步中腳和地面之間是否處于相對靜止;又或者一個玻璃杯摔落,算法是否知道它會摔碎,如果摔碎那么每一個玻璃碎片又將按照怎樣的軌跡彈出;風(fēng)吹過一片草地,每一根小草該如何隨風(fēng)舞動……所有我們在日常生活中習(xí)以為常、視若無睹的極細微運動,均遵循著物理規(guī)律,而如此龐大的物理規(guī)律的堆疊,使得“控制”成為視頻生成領(lǐng)域最為困難的一個問題。

除對視頻內(nèi)容的控制外,時間連貫性也同樣重要——如何讓角色、物體和背景在幀之間保持一致,而不會變形或扭曲,或者變換成另一個物體。如一個人在街邊走路,是否可以保證街邊景色的連貫,而正在走路的主人公,他的長相是否能夠保持一致……這是一個視頻是否可以實際使用的底線,但受限于技術(shù)的不可控性,往往很難達成。

此外,視頻長度同樣重要,且與時間連貫性密切相關(guān)。目前,許多公司限制旗下產(chǎn)品生成視頻的長度,究其原因,在于他們無法確保幾秒鐘后的畫面一致性。如果只能保證短時間內(nèi)的連貫性,那么視頻將會面臨鏡頭過多、觀感差的問題,大大降低了文生視頻應(yīng)用的可能性。

Sora為何成為文生視頻“紫微星”?

隨著今年初Sora的橫空出世,控制、時間連貫性、時長三大問題似乎都迎刃而解,大幅提升的生成質(zhì)量讓不少人直呼文生視頻領(lǐng)域的“ChatGPT時刻”已經(jīng)到來。根據(jù)OpenAI公開的技術(shù)文檔顯示,Sora主要依靠三大“秘密武器”解決了以上矛盾。

首先是DiT(Diffusion Transformer)架構(gòu)。DiT最早完整體現(xiàn)在華人學(xué)者謝賽寧教授的論文《Scalable Diffusion Models with Transformers》,后經(jīng)由OpenAI完整地工業(yè)化實現(xiàn)。簡單來講,DiT是將傳統(tǒng)的U-Net架構(gòu)替換為Transformer架構(gòu),這樣做的理由和優(yōu)勢是:當(dāng)數(shù)據(jù)集量級大時,Transformer相比于U-Net更具擴展性,更能促成龐大數(shù)據(jù)集所帶來的涌現(xiàn)能力發(fā)生。

此外,Transformer的自注意力機制還極有可能幫助Sora在視頻的時間連貫性上取得更好的表現(xiàn)。Sora可以將時間離散化,然后通過自注意力機制理解前后時間線的關(guān)系。而自注意力機制的原理就是每個時間點和其他所有時間點產(chǎn)生聯(lián)系,這是Diffusion Model所不具備的。

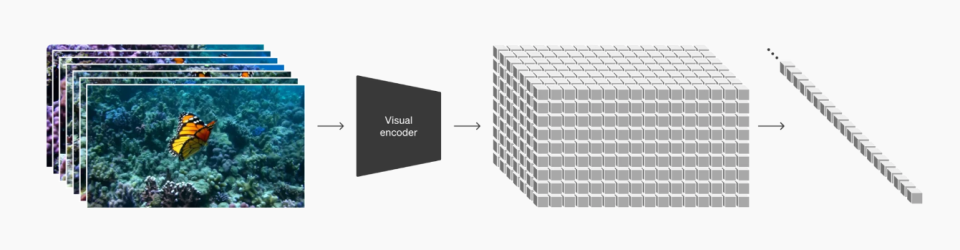

第二大“武器”,是Sora特有的視頻分解邏輯。對于沒有視覺能力、只會理解二進制的計算機來說,如何將包含三維視覺信息的視頻拆分成計算機能夠理解的格式,以進一步推進訓(xùn)練,是文生視頻技術(shù)的一大難點。目前,包括Sora在內(nèi)的大部分大模型都采用了把視頻編碼成一個一個離散的token的方式,而Sora在此基礎(chǔ)上,將視頻在三維空間中均分成一個一個小的token,被OpenAI稱為“時空補丁”(spacetime patches),更有利于最大化利用視頻數(shù)據(jù),完成OpenAI的“暴力美學(xué)”。

最后是強大的語言理解能力。在OpenAI文生圖模型DALLE3的加持下,Sora可以將許多沒有文本標(biāo)注的視頻自動進行標(biāo)注,并用于視頻生成的訓(xùn)練。同時因為有GPT的加持,可以將用戶的輸入擴寫成更加詳細的描述,使得生成的視頻獲得更加貼合用戶的輸入,并且Transformer框架能幫助Sora模型更有效地學(xué)習(xí)和提取特征,獲取和理解大量的細節(jié)信息,增強模型對未見過數(shù)據(jù)的泛化能力。

Sora解決了部分問題,但這就夠了嗎?

Sora的三大“武器”推動了文生視頻“GPT時刻”的到來,也從一定程度上解決了以上種種困擾文生視頻領(lǐng)域一年多的問題,但行業(yè)的發(fā)展速度仍遠慢于2023年初大語言模型橫空出世之時。距離Sora官宣已近半年,但真正用到這一工具的用戶仍寥寥無幾,更有不少爭議甚囂塵上。距離文生視頻技術(shù)成為真正能夠代替生產(chǎn)力的工具,我們還有哪些懸而未決的問題?

首先,高質(zhì)量的訓(xùn)練數(shù)據(jù)從何而來?相較文本、圖像等數(shù)據(jù)形式,目前全球范圍內(nèi)的高質(zhì)量標(biāo)記訓(xùn)練視頻數(shù)據(jù)都處于緊缺狀態(tài)。雖然YouTube和TikTok等視頻平臺上不乏可公開訪問的視頻,但這些原始視頻沒有經(jīng)過標(biāo)注,同時在內(nèi)容種類上也不夠多樣化。

從現(xiàn)階段來看,與專業(yè)視頻工作室、制作公司,乃至于電視臺等機構(gòu)達成合作,或許是高質(zhì)量視頻數(shù)據(jù)獲取的最優(yōu)解,而國內(nèi)顯然已有玩家開始探索這一合作模式。作為國內(nèi)首個音視頻多媒體大模型,萬興“天幕”在發(fā)布之初,就已落戶馬欄山,并與中廣天擇達成大模型算料戰(zhàn)略合作,針對中國本土數(shù)據(jù)采集進行了前瞻性布局,并且已完成了百億本土化高質(zhì)量音視頻數(shù)據(jù)沉淀,或可作為案例來借鑒。

其次,誰將負責(zé)工作流程?視頻創(chuàng)作并非單純的AI生成可滿足,而是需要動畫、字幕、音樂、特效等等資源層層結(jié)合加碼,也正因為音視頻制作鏈路的門檻和復(fù)雜性,注定了相關(guān)需求無法由單一模型“一氣呵成”。

當(dāng)前,許多創(chuàng)作者常見的創(chuàng)作流程包括從ChatGPT等語言大模型上獲取創(chuàng)作靈感、腳本及提示詞,從Midjourney等圖像大模型上通過文字生成關(guān)鍵幀畫面,在Runway等視頻大模型上通過關(guān)鍵幀延伸創(chuàng)作出動畫視頻,在Suno等音頻大模型上生成配樂,再將所有素材導(dǎo)入傳統(tǒng)剪輯軟件進行后期剪輯并制作出成品。縱觀整個流程,創(chuàng)作者需輾轉(zhuǎn)多個平臺、切換不同軟件、多次導(dǎo)入文件,由此帶來了飆升的工作量。

而采取“車間模式”協(xié)同生產(chǎn)的音視頻大模型,或許可以為此問題提出一個可能的解決方向。吳太兵認為,大模型1.0時代生成方式以文本為主并輔以跨模態(tài),內(nèi)容的可控性不高;2.0時代,垂直大模型增長趨勢明顯,好比“工匠”,可更快速、更靈活解決細分領(lǐng)域?qū)I(yè)性問題,可對“原材料”進行組裝等加工,做成“半成品”乃至“成品”,其生成模式更多是多媒體融合的方式,可從模型到應(yīng)用場景對用戶一條龍賦能。

基于此理念,萬興科技推出了萬興“天幕”,以音視頻生成式AI技術(shù)為基礎(chǔ),聚焦數(shù)字創(chuàng)意垂直場景,由視頻大模型、音頻大模型、圖片大模型、語言大模型組成,并擁有超百個AI原子能力,讓用戶能夠“一站式”完成內(nèi)容創(chuàng)作。

從2022年至今,短短不到兩年的時間內(nèi),世界見證了AI行業(yè)的飛速發(fā)展,也更加證實了未來的潛力。雖然偶有困難,但是AI視頻技術(shù)的明天無疑是光明的,它將繼續(xù)推動著我們向一個更加豐富、多元和互動的數(shù)字世界新時代邁進。

1.TMT觀察網(wǎng)遵循行業(yè)規(guī)范,任何轉(zhuǎn)載的稿件都會明確標(biāo)注作者和來源;

2.TMT觀察網(wǎng)的原創(chuàng)文章,請轉(zhuǎn)載時務(wù)必注明文章作者和"來源:TMT觀察網(wǎng)",不尊重原創(chuàng)的行為TMT觀察網(wǎng)或?qū)⒆肪控?zé)任;

3.作者投稿可能會經(jīng)TMT觀察網(wǎng)編輯修改或補充。