澎思科技打破視頻行人再識別(ReID)技術三項世界紀錄互聯網+

一舉實現在三大數據集上實現算法關鍵指標首位命中率(Rank-1 Accuracy)大幅度提升,準確率均創歷史新高。

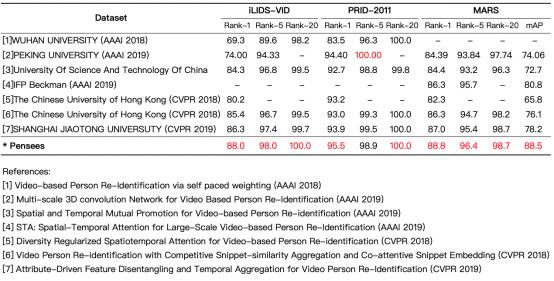

繼在三大主流單幀圖片行人再識別數據集(Market1501,DukeMTMC-reID,CUHK03)刷新世界紀錄后,近日,澎思科技(Pensees)在基于視頻的行人再識別數據集(PRID-2011,iLIDS-VID,MARS)中再次取得突破性進展,一舉實現在三大數據集上實現算法關鍵指標首位命中率(Rank-1 Accuracy)大幅度提升,準確率均創歷史新高。

刷新三大數據集世界紀錄,實現算法關鍵指標大幅度提升

PRID-2011、iLIDS-VID和MARS均為基于視頻的行人再識別數據集。PRID-2011數據集中的視頻對通過兩個固定的監控攝像頭進行采集,攝像頭A包含385個行人,攝像頭B包含749個行人。這些行人中,只有200個行人同時出現在兩個攝像頭中。iLIDS-VID是在PRID-2011之后公布的數據集,與PRID-2011相比,數據更加整齊,也更有挑戰性。iLIDS-VID數據集是通過機場到達大廳的CCTV監控視頻采集得到的,包含300個行人在兩個攝像頭下的600段視頻。視頻中存在嚴重的著裝相似,光照和視角變化,復雜背景和遮擋現象,因此識別難度大。MARS數據集是目前基于視頻ReID最大的數據集,是單幀圖片行人再識別數據集Market1501的擴充版,圖像數量由32,668幅擴展到了1,191,003幅。

與單幀圖片的行人再識別數據集一樣,首位命中率(Rank-1 Accuracy)和平均精度均值(Mean Average Precision,mAP)是衡量視頻行人再識別ReID算法水平的核心指標。澎思科技此次一舉實現在三大數據庫上,僅利用原始數據就實現Rank-1 Accuracy關鍵指標大幅度提升。目前,澎思科技算法在最大的視頻數據集MARS上的首位命中率指標已經達到88.8%,領先香港中文大學、中科大、北京大學等國內外知名機構。在iLIDS-VID和PRID-2011等數據集上首位命中率也分別達到了88.0%和95.5%。

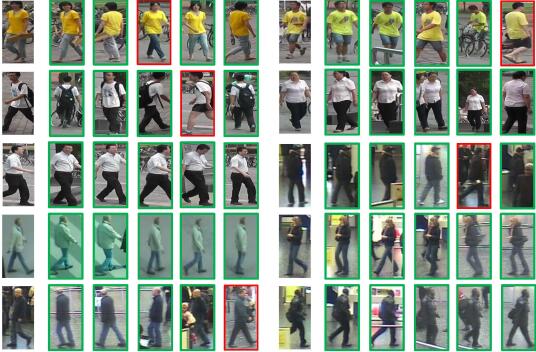

澎思科技行人再識別ReID算法在MARS數據集的部分測試結果

立足澎思現有業務,展開垂直領域技術研發和創新

澎思科技此次成果的取得源于澎思新加坡研究院對算法的自研創新和融合探索,是立足于澎思現有業務和商業模式,結合公司的發展方向針對性開展垂直領域技術研發和創新。主要包括以下幾個方面:

1、受遮擋、姿態變化、視角變化等因素的影響,視頻序列中行人的特征是不連續的。用全局特征來度量每一幀圖片的權重往往會損失掉許多重要的信息。采用分割重組策略將特定局部特征重組成多個視頻序列進行學習,進而極大減少局部特征損失對最終特征的影響。

2、其次,提出了全新的雙向圖注意力機制模塊。將圖卷積神經網絡和SENet完美結合,在整個序列上進行通道域的模式選擇學習。同時通過雙向網絡進行空間域的注意力區域學習。由于圖卷積網絡的特性,每一幀圖片的注意力特征都是與其他幀相互學習結合的結果,從而極大提高特征的代表性。

3、最終,利用幀間相似度進行序列融合。與大多數利用循環神經網絡進行融合算法相比,最大的優勢是不需要訓練額外的模型參數,僅僅通過數學計算的方式就可以達到融合的目的。這樣,數據的類內相似度得到了極大的提高。在結合三元損失函數進行訓練后,類間相似度得到了降低,進而提高重識別效果。

基于視頻的行人再識別與單幀圖片的行人再識別任務目的是相同的,即在視角不重疊的多攝像機網絡下進行行人的匹配。盡管基于單幀圖片的行人再識別算法已經取得了不錯的進步,但由于單幀圖片只包含有限的行人信息,網絡提取的特征不具備足夠的代表性,檢測結果往往受圖片質量的影響較大。

與此相比,視頻序列的優勢便凸顯出來。一個短視頻序列往往包含行人多運動狀態下的更多特征,并且利用時序信息,可以將背景、遮擋等干擾因素的影響降到最低,提升識別的準確度。

加速AI技術落地,持續推進AI產業化落地進程

基于視頻的行人再識別(ReID)技術更貼近智慧城市建設的諸多應用場景,能有效解決行人信息有限、特征不足及其他干擾因素等問題,相比單幀圖片的行人再識別具備更長遠的落地應用空間。接下來,澎思科技將進一步加大在視頻行人再識別算法上的研究,并逐步將算法應用到平安城市、智慧社區、智慧園區、智慧零售、智慧交通等實戰應用場景中。

澎思科技作為一家專注于計算機視覺和物聯網技術,提供“以人為核心”行業綜合應用解決方案的人工智能公司,在人工智能行業進入商業化落地主導的產業化階段,一方面將不斷加強自研技術創新,提升技術競爭力;另一方面堅持“行業+AI”策略,針對用戶需求深挖場景,發現行業痛點并不斷打磨算法和產品,將技術真正應用到業務場景中,推動AI技術的產品化落地和商業化進程。

1.TMT觀察網遵循行業規范,任何轉載的稿件都會明確標注作者和來源;

2.TMT觀察網的原創文章,請轉載時務必注明文章作者和"來源:TMT觀察網",不尊重原創的行為TMT觀察網或將追究責任;

3.作者投稿可能會經TMT觀察網編輯修改或補充。